La vie d’une petite famille tourne autour des jours d’école. Du coup,…

Piscine a rasoirs

Régulièrement le travail de restauration des chasses demande un temps de trempage…

Donnez la chasse a Mr. SMITH

Des fois, fouiller les archives a du bon !

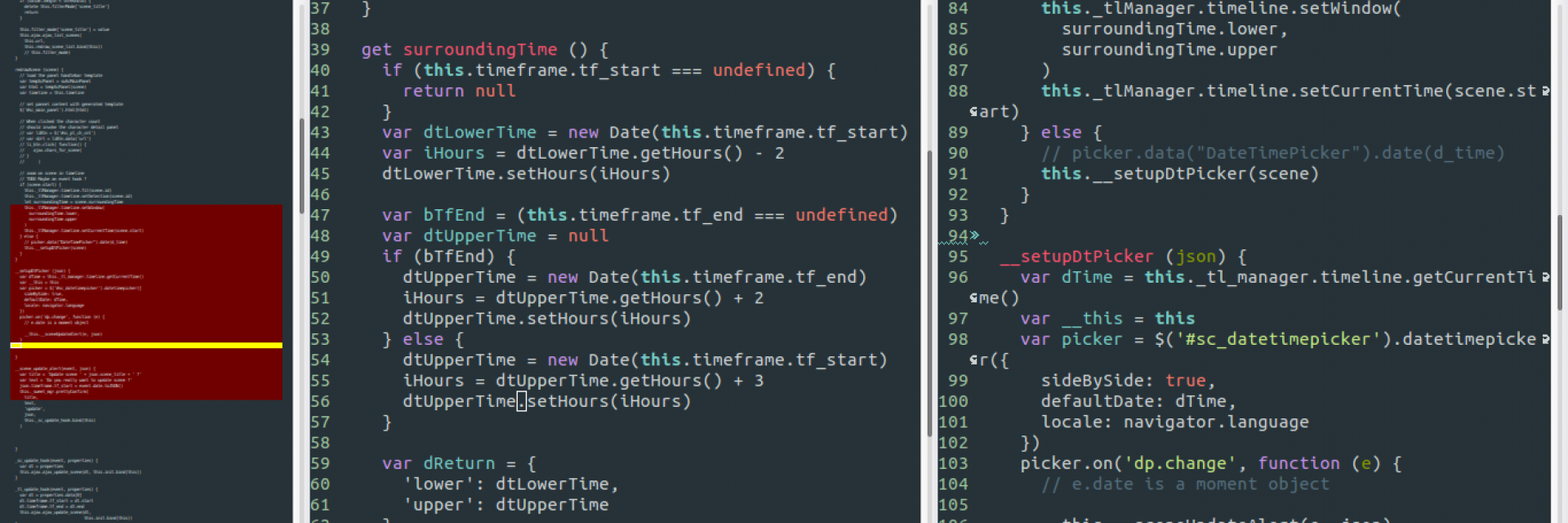

Atelier v0.2

Petit à petit j’aménage l’atelier de la maison 🙂 Comme on voit…

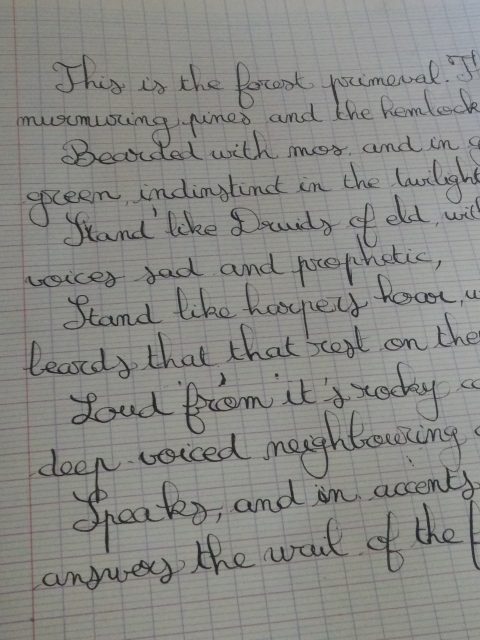

Réapprendre à écrire

Je n’ai pas envie, particulièrement, de me lancer dans tout ce qu’il…

Hop, un tableau, des clefs, tout ça

L’entrée de la maison manquait de façon flagrante d’un tableau à clefs,…

Maintenant avec 100% d’atelier en plus

Premier petit compte rendu de restauration sur cette nouvelle mouture de mon…